Theo TechSpot, Nvidia và SK hynix đang hợp tác phát triển một loại ổ SSD chuyên dụng cho trí tuệ nhân tạo, hứa hẹn tăng tốc độ xử lý dữ liệu gấp 10 lần so với các giải pháp hiện tại. Dự án này đánh dấu một bước tiến quan trọng trong việc tối ưu hóa hạ tầng lưu trữ cho các mô hình AI ngày càng phức tạp và dữ liệu ngày càng lớn.

Loại SSD mới này đang trong giai đoạn thử nghiệm, với mục tiêu cụ thể là cải thiện tốc độ truyền dữ liệu giữa bộ xử lý và bộ nhớ lưu trữ, một trong những điểm nghẽn lớn nhất trong hoạt động của các hệ thống AI. Thiết bị sẽ sử dụng bộ nhớ NAND hiệu suất cao do SK hynix phát triển, kết hợp với bộ điều khiển (controller) chuyên biệt và phần mềm tối ưu do Nvidia cung cấp.

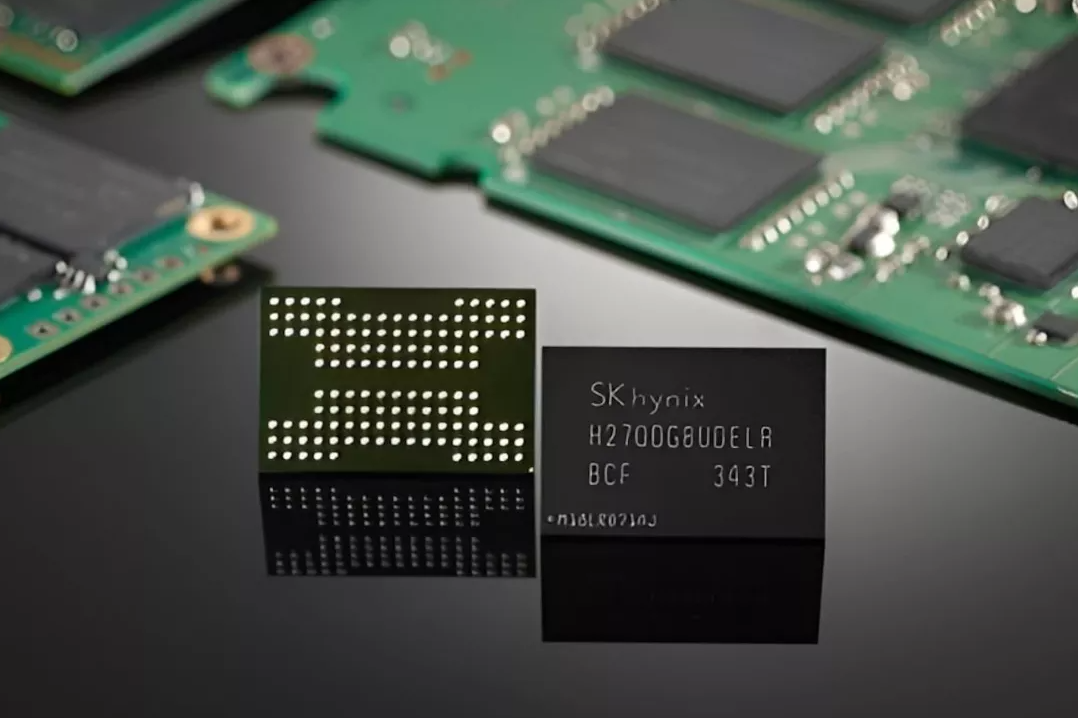

Chip nhớ NAND hiệu suất cao của SK hynix, thành phần cốt lõi trong ổ SSD AI thế hệ mới đang được phát triển cùng Nvidia

ẢNH: CHỤP MÀN HÌNH TECHSPOT

Thay vì sử dụng SSD truyền thống vốn được thiết kế để phục vụ các nhu cầu chung về lưu trữ, sản phẩm mới sẽ tập trung xử lý các yêu cầu đặc thù của AI như phân tích dữ liệu khối lượng lớn, huấn luyện mô hình và xử lý suy luận theo thời gian thực. Theo Nvidia và SK hynix, SSD AI này sẽ có khả năng giảm đáng kể độ trễ truy xuất dữ liệu và tăng hiệu suất tổng thể của các hệ thống AI.

Ngoài ra, phần mềm điều khiển SSD cũng sẽ được tinh chỉnh để hỗ trợ các mô hình học sâu, với khả năng phối hợp chặt chẽ với GPU của Nvidia. Việc này giúp giảm chi phí vận hành bằng cách tối ưu hóa lưu lượng dữ liệu và tránh tình trạng nghẽn cổ chai trong quá trình huấn luyện mô hình AI.

Dù chưa công bố tên sản phẩm hay thời điểm thương mại hóa chính thức, cả hai công ty đều cho biết dự án đang đạt tiến độ tích cực và kết quả thử nghiệm ban đầu rất khả quan. Nvidia trước đó khẳng định vai trò trung tâm trong các nền tảng AI, trong khi SK hynix là một trong những nhà sản xuất bộ nhớ lớn nhất thế giới, đặc biệt nổi bật trong lĩnh vực DRAM và NAND.

Sự hợp tác giữa hai ông lớn công nghệ cho thấy ngành công nghiệp AI đang bước vào giai đoạn tối ưu hóa không chỉ phần mềm mà cả phần cứng đi kèm. Với tốc độ phát triển nhanh chóng của các mô hình AI như ngôn ngữ lớn (LLM), nhu cầu về các giải pháp lưu trữ chuyên dụng, hiệu năng cao sẽ ngày càng trở nên cấp thiết.

Nếu thành công, SSD AI mới có thể trở thành một thành phần quan trọng trong hạ tầng AI thế hệ tiếp theo, từ trung tâm dữ liệu đến các thiết bị biên, góp phần nâng cao năng lực tính toán và giảm chi phí triển khai mô hình AI trên diện rộng.