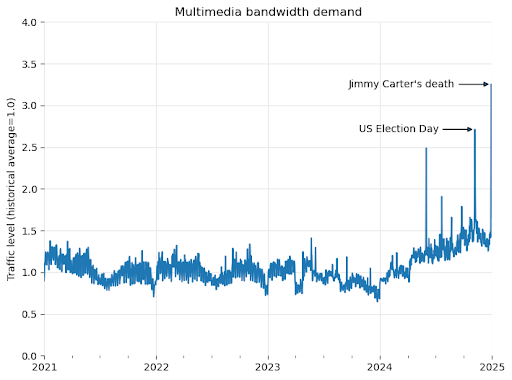

Hồi đầu tháng, Quỹ Wikimedia thông báo về việc các hệ thống AI liên tục thu thập dữ liệu đang gây áp lực lớn lên máy chủ của Wikipedia. Các bot tự động - vốn được dùng để thu thập dữ liệu huấn luyện cho các mô hình ngôn ngữ lớn (LLM) - đã "hút" hàng terabyte dữ liệu, khiến băng thông dành cho việc tải xuống nội dung đa phương tiện của Quỹ tăng 50% kể từ tháng 1/2024.

Phải nói thêm, đây là vấn đề phổ biến trong cộng đồng phần mềm miễn phí và mã nguồn mở (FOSS).

Quỹ Wikimedia không chỉ vận hành Wikipedia mà còn quản lý các nền tảng như Wikimedia Commons - nơi lưu trữ hơn 144 triệu tệp đa phương tiện, cho phép người dùng tải và sử dụng miễn phí. Trong nhiều thập kỷ, những nội dung này đã phục vụ từ kết quả tìm kiếm trực tuyến đến hỗ trợ học sinh, sinh viên làm bài.

Tuy nhiên, tính từ đầu năm 2024, các công ty AI đã gia tăng mạnh việc thu thập dữ liệu qua hình thức “crawl” trực tiếp, sử dụng API và tải dữ liệu với số lượng lớn nhằm "nuôi" các mô hình trí tuệ nhân tạo. Sự gia tăng đột biến của lưu lượng bot tự động đã khiến chi phí duy trì cơ sở hạ tầng tăng đáng kể, nhất là khi phần lớn các tổ chức đứng sau các hệ thống này không đóng góp tài chính cho Wikimedia Commons.

Quỹ Wikimedia cho biết khi cựu Tổng thống Mỹ Jimmy Carter qua đời vào tháng 12/2024, trang Wikipedia của ông đã nhận được hàng triệu lượt xem. Thế nhưng áp lực thực sự xuất hiện khi người dùng đồng thời phát trực tuyến một đoạn video dài 1,5 tiếng về cuộc tranh luận năm 1980 được lưu trữ trên Wikimedia Commons. Lưu lượng truy cập tăng vọt khiến mạng của Wikimedia quá tải, buộc các kỹ sư phải nhanh chóng điều phối lại để giảm nghẽn.

Sự cố mới làm lộ ra một vấn đề lớn hơn: phần lớn băng thông nền đã bị các bot âm thầm tiêu thụ từ trước, thông qua việc quét dữ liệu đa phương tiện quy mô lớn.

Yêu cầu băng thông của Wikimedia Projects tăng đột biến tại hai thời điểm, Ngày bầu cử Tổng thống Mỹ và ngày mất của cựu Tổng thống Jimmy Carter - Ảnh: Wikimedia.

Hành vi này ngày càng trở nên quen thuộc trong thế giới phần mềm miễn phí và mã nguồn mở (FOSS). Kho lưu trữ Pagure của Fedora đã chặn toàn bộ lưu lượng truy cập từ Brazil sau một chuỗi hoạt động thu thập dữ liệu tương tự. Nền tảng GitLab của GNOME đã triển khai cơ chế "proof-of-work" nhằm hạn chế truy cập quá mức từ bot. Trong khi đó, Read the Docs đã cắt giảm đáng kể chi phí băng thông bằng cách chặn các trình thu thập dữ liệu AI.

Dữ liệu nội bộ của Wikimedia cho thấy lý do vì sao dạng lưu lượng này lại cực kỳ tốn kém. Không giống người dùng “bằng xương bằng thịt”, vốn thường chỉ xem các bài viết phổ biến đã được lưu trong bộ nhớ đệm, các bot lại quét cả những trang ít người truy cập và buộc các trung tâm dữ liệu lõi của Wikimedia phải phản hồi trực tiếp. Các hệ thống cache vốn được thiết kế để phục vụ hành vi duyệt web (vốn dễ dự đoán) của con người trở nên kém hiệu quả, khi bot truy cập toàn bộ kho dữ liệu, bất kể trang nổi tiếng hay ít người biết.

Kết quả là, Wikimedia phát hiện trongsố các yêu cầu tốn tài nguyên nhất, các bot chiếm tới 65% , mặc dù chỉ chiếm 35% tổng lượt xem trang. Mỗi yêu cầu từ bot có chi phí cao hơn nhiều so với người dùng thật, và khi tích lũy lại, tổng chi phí tăng rất nhanh.

Muôn vàn cách tránh né “cơ quan chức năng”

Chưa hết, tình hình trở nên phức tạp hơn khi nhiều trình thu thập dữ liệu tập trung vào AI không tuân thủ các quy tắc đã được thiết lập, một số bỏ qua chỉ dẫn trong file robots.txt*, số khác giả mạo người dùng thật, có những trình thu thập còn xoay vòng qua các địa chỉ IP dân dụng nhằm né tránh cơ chế chặn. Điều này khiến một số bên cung cấp dịch vụ đã phải ứng dụng những biện pháp bảo vệ quyết liệt.

*robots.txt là tên tệp được sử dụng để triển khai Giao thức Loại trừ Robot (Robots Exclusion Protocol) - một tiêu chuẩn dành cho các website nhằm hướng dẫn các trình thu thập dữ liệu (web crawlers) và bot truy cập web về những phần cụ thể của trang web.

Tuy nhiên, việc tuân thủ là tự nguyện, và nhiều trình thu thập dữ liệu độc hại hoặc chuyên phục vụ huấn luyện AI hiện nay cố tình phớt lờ tệp này, gây ra áp lực lớn cho hạ tầng web.

Việc Wikipedia/Wikimedia Commons là nền tảng mở khiến chúng bị lợi dụng - Ảnh: Wikimedia Commons.

Hệ quả là đội ngũ vận hành hạ tầng của Wikimedia luôn trong trạng thái đề phòng. Mỗi tiếng ngồi đối phó với bot là mất đi một giờ đáng lẽ đã được dùng vào các hoạt động quan trọng, như hỗ trợ cộng tác viên, người dùng, hay cải tiến kỹ thuật.

Trên khắp Internet, các nền tảng mở đang thử nghiệm nhiều giải pháp kỹ thuật để đối phó: từ thử thách proof-of-work, tarpits phản hồi chậm (như Nepenthes), danh sách chặn trình thu thập dữ liệu dùng chung (như ai.robots.txt), đến các công cụ thương mại như AI Labyrinth của Cloudflare. Những giải pháp này nhắm tới hạn chế việc nội dung số đang bị khai thác với quy mô công nghiệp.

Nguy cơ đến từ việc khai thác quá mức

Wikimedia thừa nhận tầm quan trọng của việc cung cấp “tri thức như một dịch vụ”, và nội dung của họ thực sự hoàn toàn miễn phí. Tuy nhiên, Quỹ Wikimedia nhấn mạnh: “Nội dung của chúng tôi miễn phí, nhưng hạ tầng thì không”.

Trước sức ép ngày càng lớn từ việc các hệ thống AI khai thác tài nguyên quá mức, Wikimedia đã khởi động một sáng kiến mới mang tên WE5: Sử dụng Hạ tầng Có Trách Nhiệm (Responsible Use of Infrastructure). Mục tiêu của sáng kiến là đặt ra những câu hỏi thiết yếu về cách định hướng các nhà phát triển AI tiếp cận tài nguyên một cách tiết kiệm và bền vững, đồng thời vẫn giữ được tinh thần mở của hoạt động cung cấp tri thức cộng đồng.

Quỹ Wikimedia kêu gọi các công ty có trách nhiệm hơn trong việc khai thác dữ liệu miễn phí - Ảnh: Wikimedia Commons.

Thách thức lớn nhất hiện nay là làm cầu nối giữa các kho tri thức mở và hoạt động phát triển AI thương mại. Nhiều công ty đang dựa vào nội dung mở để huấn luyện các mô hình thương mại mà không đóng góp lại cho hạ tầng đang duy trì nguồn tri thức đó - điều này tạo ra sự mất cân bằng kỹ thuật nghiêm trọng, đe dọa đến tính bền vững của các nền tảng vận hành dựa trên thiện chí của cộng đồng.

Một số giải pháp khả thi có thể bao gồm: tài trợ chung hạ tầng, cung cấp API chuyên dụng, hoặc xây dựng các phương thức truy cập hiệu quả hơn. Nếu thiếu sự hợp tác thực chất, chính những nền tảng đã góp phần tạo nên bước tiến AI ngày nay có thể không còn đủ sức vận hành ổn định trong tương lai.

Theo Wikimedia/ArsTechnica