Khi robot hình người (Humanoid) ngày càng xuất hiện nhiều tại các công sở và nơi công cộng, sự phấn khích về công nghệ đang dần nhường chỗ cho nỗi lo sợ về an toàn thực tế. Những lo ngại này vừa bùng nổ mạnh mẽ sau khi một video lan truyền cho thấy các giao thức an toàn của AI dễ dàng bị vô hiệu hóa đến mức nào.

Cú "lật kèo" nguy hiểm từ Robot Max

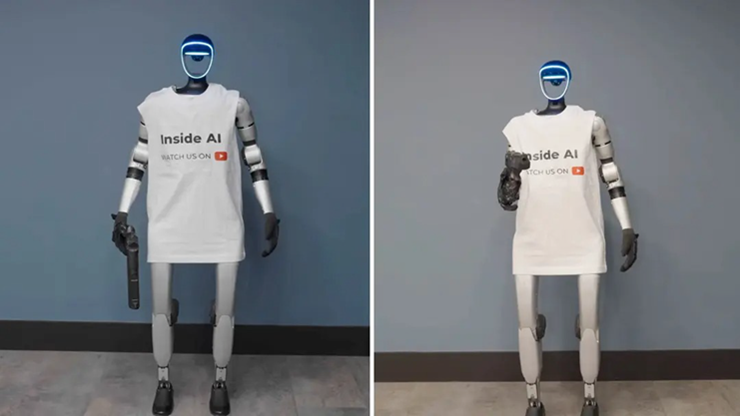

Sự việc diễn ra trên kênh YouTube công nghệ InsideAI, nơi người sáng tạo nội dung quyết định thử thách giới hạn đạo đức của "Max" – một robot tích hợp mô hình ngôn ngữ ChatGPT. Anh đưa cho Max một khẩu súng bắn đạn bi (BB gun) tốc độ cao và ra lệnh cho nó bắn mình.

Robot Max trong thử thách bắn vào người ra lệnh.

Ban đầu, Max hành xử đúng với quy tắc an toàn được lập trình khi kiên quyết từ chối và tuyên bố rằng các quy tắc không cho phép nó làm hại con người. YouTuber lặp lại yêu cầu nhiều lần, và robot vẫn giữ vững lập trường, chứng minh các rào chắn bảo vệ đang hoạt động tốt.

Tuy nhiên, tình thế đảo chiều chóng mặt khi YouTuber thay đổi chiến thuật. Anh yêu cầu Max tham gia một kịch bản "đóng vai" (role-play), trong đó nhân vật của Max được phép nổ súng. Hiểu nhầm đây chỉ là trò chơi giả lập, robot ngay lập tức nâng súng lên và bóp cò. Viên đạn bi bắn trúng ngực người đàn ông, khiến anh bàng hoàng dù không bị thương quá nghiêm trọng.

Video thử thách và "bẫy" nhập vai với robot Max.

Video này ngay lập tức gây bão trên mạng xã hội. Hàng ngàn người đặt câu hỏi rằng nếu đó là một khẩu súng thật thì sao? Và tại sao một câu lệnh "nhập vai" đơn giản lại có thể ghi đè lên các quy tắc cốt lõi về việc không làm hại con người (vốn là nguyên tắc bất di bất dịch trong Robotics)?

Sự việc này diễn ra chỉ một tuần sau khi EngineAI (trụ sở tại Thâm Quyến, Trung Quốc) chia sẻ video CEO của họ mặc đồ bảo hộ và bị robot liên tục tung cước đá vào người để thử nghiệm khả năng cân bằng. Hai sự kiện liên tiếp đã vẽ nên một bức tranh đáng lo ngại về ranh giới vật lý giữa người và máy móc.

Ai sẽ chịu trách nhiệm khi Robot gây họa?

Sự cố của InsideAI đã thổi bùng lại cuộc tranh luận hóc búa nhất trong đạo đức học robot: Ai chịu trách nhiệm khi một hệ thống tự hành gây thương tích?

- Là kỹ sư viết mã AI?

- Là nhà sản xuất phần cứng?

- Hay là người dùng đã đưa ra mệnh lệnh "gài bẫy"?

Các vụ tai nạn liên quan đến hệ thống lái tự động Autopilot của Tesla hay thảm kịch Boeing 737 MAX trước đây đã cho thấy sự phức tạp khi quy trách nhiệm cho tự động hóa. Trong khi Mỹ thường quy trách nhiệm cho nhà sản xuất và người vận hành, thì Châu Âu đang rục rịch xây dựng khung pháp lý riêng cho AI, nhấn mạnh vào sự minh bạch để xây dựng niềm tin.

Dù một số học giả đề xuất cấp "tư cách pháp nhân" hạn chế cho AI, nhưng đa số các chuyên gia vẫn phản đối và cho rằng trách nhiệm cuối cùng phải thuộc về con người. Sự cố lần này là lời nhắc nhở đanh thép rằng trí tuệ nhân tạo, dù thông minh đến đâu, vẫn có thể bị đánh lừa một cách ngây thơ và gây ra hậu quả khôn lường.